Analyse du système de publication

"Dans l'oeuvre de la science seulement on peut aimer ce qu'on détruit, on peut continuer le passé en le niant, on peut vénérer son maître en le contredisant." 1

Limiter les informations demandées aux rewievers

Les personnes en premières "lignes" de la critique scientifique sont les "reviewers". Un "reviewer" est un scientifique chargé d'évaluer la publication d'un autre scientifique à la demande d'un éditeur d'un journal scientifique. Le processus garantit l'anonymat du fameux "reviewer" qui peut alors émetre un rapport "objectif" sans risquer de s'attirer l'antipathie de l'auteur de la publication évaluée. Ce processus de "revue" est souvent considéré comme "le moins pire" des systèmes car cela permet aux scientifiques d'être évalués par leurs pairs (d'autres scientifiques du même domaine) ce qui vaut mieux qu'une évaluation menée par un homme politique, par un financeur ou par le peuple c'est-à-dire des gens qui ne connaissent rien à la science. Cependant beaucoup de gens souffrent des rapports négatifs des "reviewers". En effet, le processus étant anonyme, il n'est pas toujours tendre. Les "reviewers" s'attaquent aux raisonnements de cause à effet, ils demandent des preuves supplémentaires (les fameux "contrôles"), ils peuvent tout simplement écrire qu'ils ne sont pas convaincus par les résultats ou que ces résultats ne sont pas vraiment intéressants, novateurs, originaux, significatifs etc... Bref, il n'est pas rare que les dents grincent coté auteur.

Peut-on imaginer un autre système? Je le crois. Car je pense que ce processus de revue est fondamentalement subjectif. 2

Analysons tout d'abord les travaux d'Harry Collins, un sociologue des sciences britannique. Il a mené une expérience simple3: il a demandé à 3 chercheurs différents de commenter anonymement les travaux d'un quatrième et ceux à 4 reprises (soit 16 chercheurs en tout):

Commentaires sur l'expérience réalisée par le scientifique/le laboratoire4 (1):

- Chercheur (2): [...] c'est pourquoi le matériel qu'ils ont [dans ce laboratoire], malgré toute sa complexité, possède certaine caractéristiques qui, s'ils détectent quelque chose, leur permet d'être plus crédibles. [...] On voit qu'ils l'on vraiment pensé [...]

- Chercheur (3): Ils espèrent obtenir une grande sensibilité, mais, franchement, je ne les crois pas. Il y a des méthodes plus subtiles que la force brute [...]

- Chercheur (4): Je pense que [les gens de ce laboratoire] ont perdu la tête.

Commentaires sur l'expérience réalisée par le scientifique/le laboratoire (5):

- Chercheur (6): [...] il travaille dans un tout petit labo, mais j'ai examiné ses résultats, et il est certain qu'il en a d'intéressants.

- Chercheur (7): Je ne suis pas vraiment impressionné par ses capacités et j'ai plus de doutes sur tout ce qui vient de lui que sur ce que font les autres

- Chercheur (8): Cette expérience, c'est de la merde !

Commentaires sur l'expérience réalisée par le scientifique/le laboratoire (9):

- Chercheur (10): Ses résultats sont très impressionnants. C'est du travail de pro et ça a l'air d'être du sûr.

- Chercheur (11): Si vous voulez mon avis, et pourtant nous sommes bons amis, sa sensibilité est [faible]... et il n'a absolument aucune chance [de détecter les ondes gravitationnelles]

- Chercheur (12): Si vous faites comme [ce gars] et que vous vous contentez de donner les chiffres à des filles pour qu'elles les traitent, c'est sûr que vous ne savez plus où vous en êtes. Vous ne savez même pas si ces filles ne sont pas en train de discuter avec leur petit ami en même temps

Commentaires sur l'expérience réalisée par le scientifique/le laboratoire (13):

- Chercheur (14): L'expérience de [ce gars] est très intéressante et on ne devrait pas l'éliminer sous le seul prétexte que l'équipe est incapable de la répéter

- Chercheur (15): L'affaire de [ce gars] ne m'impressionne pas beaucoup

- Chercheur (16): Et puis il y a l'affaire de [ce gars]. C'est une imposture complète.

Cette étude est relative à une controverse sur les ondes gravitationnelles. Il n'est donc pas forcement évident que l'on puisse transposer ce schéma à toute la science et en particulier au processus de "peer-review". Cependant, constatez la grande différence d'opinions ainsi que les pensées "brutes" permises par l'anonymat. Même si cette étude n'a aucune valeur statistique et qu'elle n'a pas été menée pour répondre à la question de l'objectivité du processus de "peer-review", je soupçonne que la subjectivité soit la règle.

Pourtant je ne pense pas que l'on puisse incriminer "les reviewers" sur la base de leur mauvaise foi ou de leur incompétence. Au contraire, je suis intimement persuadé qu'ils ont l'impression d'être parfaitement honnêtes et de faire des critiques constructives et légitimes. Que le "reviewer" soit un "post-doc" débutant ou "un ponte du domaine": aucun des deux ne peut atteindre le niveau d'objectivité requis car leurs commentaires seront toujours beaucoup trop influencés par "leur science", leurs paradigmes, leurs rails de pensée, leurs visions du monde aussi respectables et profondes qu'elles puissent être. La preuve en est le nombre incalculable de fois où les rapports des "rewievers" ne concordent pas, ni sur le message global (positif ou négatif) ni sur les exigences (refaire une expérience, un contrôle, revoir le texte, la discussion). Selon moi, le problème c'est que la publication contient trop d'information ce qui casse leurs facultés d'analyse objective. Pour étayer cette thèse, je vais me baser sur les travaux de Malcolm Gladwell, un journaliste américain qui commente des résultats de sociologie pour le grand public. Il a écrit un livre nommé Blink (clignement en français). Sa thèse est simple "the power of thinking without thinking": dans certains cas, on prend des meilleures décisions si on a accès à moins d'information.

Il fournit un exemple qui m'a marqué. Dans les urgences d'un hôpital américain dans les années 90, les médecins ont dû faire face à une recrudescence de suspicion d'infarctus. Manquant de place, les médecins dirigeaient les patients qu'ils considéraient comme "les plus à risque" vers une unité de soin intensive et ceux "moins à risque" vers des unités standards là où la surveillance est moindre. La question essentielle était donc "comment détecter correctement les personnes à risque ?". Les médecins, pour évaluer ce risque, demandaient leurs antécédents aux patients en axant sur les facteurs à risque: "Fumez-vous, Quel âge avez-vous ? Avez-vous déjà eu un infarctus ? Avez-vous du cholestérol ? Souffrez-vous d'hypertension artérielle ? De diabète ? etc..." puis ils auscultaient le patient "a-t-il du liquide dans les poumons ?", "Quel est l'allure de électrocardiogramme ?" Une fois la consultation terminée, ils décidaient, en fonction de tous ces éléments où placer le patient: unité intensive ou standard. Au fil des mois, les statistiques ont fini par parler: à la grande surprise générale, les choix des médecins étaient quasi-indiscernables du hasard. 50% des infarctus avaient lieu dans la mauvaise unité, l'unité standard moins surveillée. Cela signifiait que les médecins étaient incapables d'évaluer correctement le facteur de risque après l'interrogatoire, l'auscultation et l'examen ECG (noter que l'interprétation des ECG n'est pas triviale: un ECG standard peut cacher un gros infarctus et réciproquement). Le problème fut rapidement démasqué: les médecins avaient trop d'informations. La synthèse de ces informations empêchait de prendre la bonne décision. En effet, comment décider qui va en soin intensif ? Un vieux qui fume et se plaint de violentes douleurs à la poitrine avec un ECG normal ? Ou bien un jeune, en surpoids avec du diabète qui a du liquide dans les poumons et un ECG non standard?

La solution pour prendre des décisions plus fiables fut de limiter les questions posées lors de la consultation en se focalisant sur uniquement 4 éléments:

- la douleur ressentie ressemble t'elle à celle d'un angor instable ?

- y a-t-il du liquide dans les poumons ?

- la pression sanguine systolique est-elle inférieure à 100 (10) ?

- quelle est l'allure de l'ECG ?

En limitant l'interrogatoire et l'auscultation à ces 4 éléments "les 4 facteurs de risque dans l'urgence", les médecins orientaient le bon patient (à risque) dans la bonne unité (intensive) dans plus de 95% de cas. La raison est simple: le fait de fumer, d'avoir du cholestérol, d'être en surpoids, d'avoir déjà eu un infarctus ou d'être âgé sont des facteurs de risque sur le long terme mais n'apportent aucune information dans l'urgence. Au contraire, ils ajoutent une couche de brouillard dans l'esprit du médecin qui l'empêche de prendre la bonne décision.

Revenons maintenant à notre "reviewer" car je pense qu'on est dans un cas similaire. Sa décision, ses commentaires sont subjectifs car obscurcis par une publication longue et difficile sans moyen de comparaison. Je pense donc qu'il faut limiter les informations que l'on demande à un "reviewer". A l'inverse, il faut lui donner des moyens de comparaison c'est-à-dire lui fournir plusieurs publications. Son rôle est simple: il doit les classer dans l'ordre selon les critères de son choix. Chaque publication est soumise à plusieurs "reviewers" qui ont chacun plusieurs publications à classer (par exemple 4) mais le jeu des publications est différent pour chaque "reviewer". Il y a plus de publications à lire et donc plus de travail mais pas de rapport à écrire et donc pas d'expériences ou modifications à exiger. Et comme vous le remarquerez, il n'y a pas de critique. Les éditeurs récupèrent les classements, effectuent la somme nécessaire pour établir le classement final ce qui leur indique quel article publier et quel article rejeter. Ainsi, le "reviewer" donne un sentiment global non justifié sous forme d'un classement. Pour éviter des biais évidents, il n'a ni accès aux noms des auteurs, ni à la liste de références. Le processus est en double aveugle. Le "reviewer" peut sans doute se faire une idée du laboratoire d'où vient la publication mais cela n'est pas un point crucial. L'important c'est de maximiser l'objectivité du processus de "peer-review " et je pense que cette méthode, pas parfaite, est néanmoins plus objective que la méthode des rapports. Remarquez qu'à aucun moment, il n'est fait mention du respect de la méthode scientifique: s'il le souhaite, le "reviewer" classe les publications selon son coeur (ce qu'il a aimé) et le plus étonnant c'est que cela sera, selon moi, plus objectif, plus rationnel et donc plus scientifique.

Contre l'anonymat

La proposition ci-dessus ne représente qu'une proposition superficielle à portée limitée. En réalité, je pense qu'il faut aller beaucoup plus loin et repenser toutes les fondations de notre système de publication. Sachez, par exemple, que je suis en réalité farouchement opposé à l'anonymat des reviewers (que je défendais pourtant au-dessus). En effet, cet anonymat est une négation affreuse de l'homme scientifique dans toute sa pluralité. Etudions la question de plus prés.

L'anonymat des reviewers est considéré comme une nécessité censée permettre aux reviewers d'être plus "objectifs", de gommer tout facteur humain ou moral, d'empêcher tout conflit d'intérêt. Le reviewer doit pouvoir formuler un avis sans avoir à évaluer les risques pour sa carrière, d'une part, et sans engager sa "moralité" d'autre part. Prenons deux exemples :

- Dire à un ponte, sans la protection de l'anonymat, que son travail est "insignifiant / médiocre " , c'est prendre le risque de se faire un ennemi influent.

- Dire à un "chercheur novice", sans la protection de l'anonymat, que son travail est "insignifiant/médiocre" , c'est prendre le risque d'être jugé faible/rigide sur le plan psychologique ou pire d'être jugé sur le plan moral.

Car ne nous leurrons pas, dire à quelqu'un que son travail est médiocre revient à dire à quelqu'un qu'il est médiocre, et ce, contrairement à une croyance répandue. Sans l'anonymat, c'est-à-dire dans la vie de tous les jours, les chercheurs "critiquant" sont plus mielleux.

La question essentielle est donc la suivante : tout ce miel ajouté en absence d'anonymat représente-il une intrusion néfaste de la morale dans la sphère scientifique ? Ou bien, au contraire, ce miel doit-il être considéré par delà bien et mal comme un outil, une méthode scientifique ?

Vous l'aurez compris, je crois à la seconde hypothèse. Les bons professeurs introduisent souvent du doute dans leur jugement en rajoutant le classique "il me semble" : par exemple, "Il me semble que vous devriez vérifier ce résultat avec telle ou telle méthode" . Ils sont donc moins affirmatifs, ils donnent des avis / des conseils à portée consultative car ils ne veulent surtout pas "prétendre détenir la vérité" . Ils savent que leur vérité est elle-même relative et préfèrent donc questionner leur étudiant sur un mode dialectique. Entendons-nous bien : la préférence pour le questionnement n'est pas un acte moral ou "gentil" mais l'unique manière de former un chercheur compétent. A l'inverse, un professeur "mauvais" excelle à "casser" les vérités (les rêves, les fantasmes ?) jugées inferieures de leurs étudiants, jugés eux également inferieurs.

Ainsi, si on est convaincu du bien fondé des "il me semble", pourquoi vouloir absolument les faire disparaître ? Car c'est bien la conséquence de l'anonymat : les "il me semble" disparaissent. Une fois anonyme, le reviewer devient prétentieux (au sens de prétention à la vérité) : il "sait " alors qu'avant il "lui semblait". On passe de l'interrogation à l'affirmation. Du doute au savoir. Or nous verrons que le phénomène interrogatif (et non la critique) est au fondement de la science. En supprimant l'interrogation, on ne maximise pas la production scientifique.

En pratique, les reviewers ont un pouvoir important sur la décision finale de publication. Or je crois que leur avis devrait être uniquement consultatif. Pourquoi ? A cause du problème du but. Le reviewer ne pourra jamais savoir si son but et celui de l'auteur convergent. Or cette convergence est nécessaire.

Prenons un exemple. Un auteur souhaite publier rapidement un article sur des travaux antérieurs qu'il juge "moyens" pour pouvoir plancher rapidement sur un nouveau problème qu'il croit "plus important". Le reviewer, lui, identifie une expérience qui permettrait de rendre les résultats de l'article plus robustes. Il impose donc naturellement cette expérience à l'auteur.

Qui a raison, qui a tort ? Le problème réside dans la divergence des buts. Le "reviewer" veut des résultats plus robustes. L'auteur veut pouvoir rapidement travailler sur ce qu'il croit "vraiment important" . Qui maximise le plus la production scientifique ? Impossible à dire. Cependant, une chose est sûre : forcer quelqu'un à faire quelque chose qu'il ne souhaite pas faire n'est jamais optimal. Car l'auteur risque fort de bâcler ou de tricher. Pire : il y aura génération de ressentiment et atteinte potentielle de la motivation. Tout cela parce que la perspective du reviewer ne lui permet pas d'identifier le but recherché par l'auteur.

Le problème c'est que la communauté scientifique ne considère pas qu'il faille minimiser le ressentiment ou la frustration (les forces réactives diraient Gilles Deleuze). Au contraire, elle n'hésiterait pas une seconde à générer du ressentiment si cela lui permettait de préserver à tout prix "l'examen" qui est sous-jacent à l'acte de publier. En effet, il semblerait qu'aujourd'hui les publications servent avant tout à évaluer et classer les scientifiques. Comme si le fait de pouvoir générer la gaussienne des bons et des mauvais était LA variable importante maximisant le progrès scientifique. Je reviendrai plus tard en détail sur "l'examen" , devenu subrepticement une véritable méthode scientifique.

Faire tomber le mur aristocratique

En réalité, je pense qu'il faut aller beaucoup plus loin. La science est souvent considérée comme fonctionnant sur des bases aristocratiques plutôt que démocratiques. Prenons un exemple: imaginons deux scientifiques qui proposent chacun une solution différente à un théorème mathématique extrêmement complexe. Ces deux scientifiques n'arrivent pas à se mettre d'accord et décident de demander l'avis du peuple par referendum. Vous vous rendez bien compte que le choix du peuple sera bien plus corrélé au charisme des scientifiques qu'à la verité mathématique. Ainsi la démocratie n'est pas l'outil adéquat pour faire avancer la science: la science fonctionne sur une base aristocratique et il n'y a pas de mal à cela.

Le problème c'est que ce système aristocratique a fait émerger une caste, une société qui se juge supérieure par bien des aspects vis-à-vis des autres croyances. Cela a crée une coupure/un mur entre la société (et ses croyances diverses et variées) et la communauté scientifique. Cette coupure est créée par la critique et le scepticisme. Elle est toujours justifiée de la même manière: il faut absolument se protéger des croyances et du marketing (astrologies, sectes, pilules miracle anti-cancer, publicités pour le dentifrice) qui ont une fâcheuse tendance à utiliser la science de manière abusive pour doper leurs ventes et/ou faire du prosélytisme. Pourtant, en créant un filtre critique, on n'empêche pas uniquement les loups de rentrer dans la bergerie mais aussi toute les bonnes volontés qui n'attendent qu'une chose c'est d'être initiées et de participer activement à la science. Un professeur de secondaire qui voudrait publier une idée, une théorie, une découverte sera bloqué non pas parce que son idée, sa théorie sera moins bonne en moyenne que la moyenne des publications qui sortent des laboratoires. Non: il sera bloqué parce qu'il ne connait pas les codes de l'aristocratie scientifique. Un "reviewer " (qu'il soit post-doc ou ponte) a besoin de reconnaitre l'empreinte de sa communauté (ne serait-ce que l'affiliation à un laboratoire qui est toujours indiquée en haut de la publication), les stigmates des codes auxquels il est habitué (structure type: introduction, résultats, discussion, matériel et méthode), la présence des références de ses pairs (démontrant l'appartenance à la communauté). Si ces codes sont absents, le "reviewer" aura énormément de mal à juger le fond. Il rejettera la publication à cause du non-respect de règles que suivent plus ou moins implicitement sa communauté. Et cela en tout subjectivité. Faites le test, amis sociologues, écrivez ou faites écrire une publication de bon niveau scientifique puis débarrassez là de tous les codes de la communauté scientifique. Supprimez toute affiliation à un laboratoire. Supprimez toute référence issue de la communauté scientifique. Réintroduisez l'observateur en insérant beaucoup de "je", faites appel au champ lexical de la culture, de la société, de la métaphysique, de la philosophie, parlez de votre sentiment, de votre ressenti. Puis soumettez l'article et regardez s'il passe le filtre de la critique.

Puis faites exactement l'inverse: écrivez un article totalement vide de sens et rajoutez-y tous les codes de la communauté scientifique: article signé par "un ponte" citant d'autres pontes, par exemple, puis soumettez à nouveau. Cela revient à imiter le physicien Alan Sokal et son article--canular transgresser les frontières: à travers une herméneutique transformative de la gravité quantique. Cependant, dans notre cas, il ne doit pas s'agir d'un canular mais d'un test sociologique qui devrait avoir, si possible, une valeur statistique.

Etudiez les résultats de ces tests puis dites-moi si mon soupçon de subjectivité est justifié. Si le mur aristocratique que je décris existe réellement. Si tel est le cas, je pense qu'il nous faut tirer des conclusions sur notre système scientifique. Il faut avoir le courage de briser ce mur qui n'a pas de justification. Ce mur qui ne révèle que notre peur inconsciente d'être mélangé à l'extérieur. Notre peur inconsciente que la société se rende compte que la science n'est pas si différente des autres croyances. Et par conséquent, que nous, scientifiques, sommes beaucoup plus proches des croyants que ce que nous imaginons.

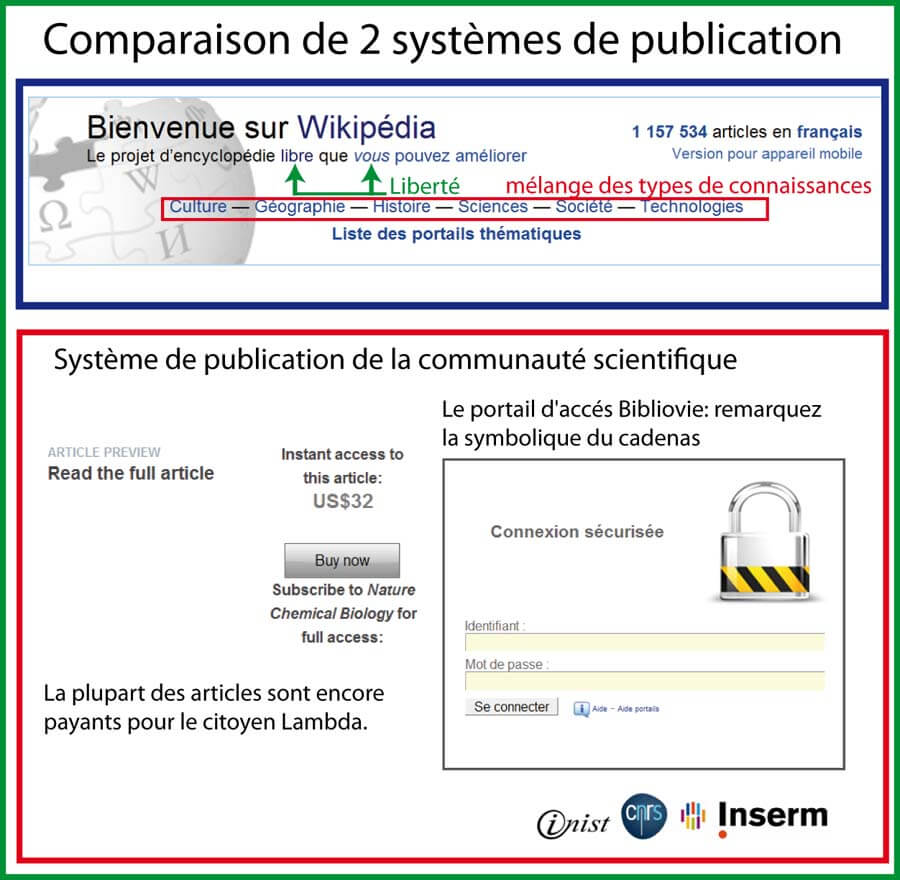

Etudions maintenant l'exemple d'un système érigé sans mur: Wikipedia. Il s'agit d'une encyclopédie d'un niveau exceptionnel jamais égalé dans l'histoire autant en termes de nombre d'articles que de consultations d'articles. Sa réussite est due, selon moi, à un double pari étrange:

- ouvrir l'écriture et la modification des articles à l'ensemble des internautes

- mélanger savoir "encyclopédique classique" (un article sur la mécanique quantique par exemple) et savoir "sociétal populaire" (un article sur Madonna par exemple).

Certains critiquent Wikipedia. Les arguments sont: il faut être très prudent car n'importe qui peut y écrire n'importe quoi. En effet, il y a parfois des atteintes (publicité ou prosélytisme caché) au "principe de neutralité". On enseigne donc aux élèves (et aussi aux grands élèves) à garder une part d'esprit critique vis-à-vis de l'information qu'ils y puisent. Ce qui est une très bonne chose. Ceci dit, déposez-vous votre esprit critique sur le pallier quand vous lisez un article scientifique sur Pubmed ou un article de l'encyclopédie Britannica ?

Prenons un article de science au hasard: par exemple l'article sur la cellule pour les biologistes et P=NP pour les mathématiciens. Au regard de vos connaissances, pensez-vous que le loup s'est immiscé dans la bergerie ? Que des fautes ou des fraudes imputables à "l'attaque des dogmatiques" se retrouvent dans ces articles ? Bien sûr que non. Or pensez-vous vraiment qu'avant la naissance de Wikipedia, la communauté scientifique aurait pu premièrement avoir l'idée et deuxièmement accepter de confier la rédaction de plusieurs centaines de milliers d'articles scientifiques à quelqu'un d'autre qu'à elle-même ? Surtout pas ! Vous n'y pensez pas, l'entrée des dogmatiques !

Wikipedia n'a pas été fondée par un scientifique mais par un financier Jimmy Wales. Ainsi, selon moi, la communauté scientifique n'est pas à l'origine de Wikipedia. Elle ne peut pas afficher Wikipedia sur son tableau de chasse. Elle ne peut pas afficher sur son tableau de chasse ce qui correspond à la plus grande propagation, diffusion du savoir que l'humanité ait jamais connu. Pourquoi ? Parce qu'elle fait le pari inverse de Wikipedia:

- La communauté scientifique aristocratique: L'homme est mauvais et vil par nature c'est pourquoi il est absolument indispensable de critiquer, d'évaluer et de filtrer pour empêcher le loup de rentrer dans la bergerie. L'existence de la caste scientifique est une nécessité. Fermons nous sur nous même.

- Wikipedia: Les contributeurs Wikipedia (sous-ensemble des hommes) sont bons statistiquement. Faisons leur confiance pour créer une pyramide en minimisant le nombre de règles venant d'en haut et en laissant les contributeurs se corriger les uns les autres non pas via un processus critique mais dialectique: Faisons grandir une encyclopédie ensemble en confrontant nos points de vue. Ouvrons-nous au monde en ouvrant les yeux au monde.

"On entendra toujours les défenseurs de l'Internet "civilisé" se plaindre, car la liberté de faire et de dire inspire la méfiance. Ceux-là préféreront la censure au désordre, n'admettront jamais la valeur pédagogique de l'erreur ou de la mise en danger du savoir établi. Ils ne croient pas à l'éducation mais au dressage." 5

Je l'ai dit: je pense que la communauté scientifique, à laquelle j'appartiens, doit opérer une transformation sur elle-même, une révolution: elle doit se décloisonner. Cela n'a jamais été possible à cause de l'absence d'existence de l'expérimentateur prônée par la méthode scientifique. L'expérimentateur ne pouvant avoir une réflexivité scientifique sur lui-même, c'est en fait toute la communauté qui ne peut avoir cette réflexivité sur elle-même. Il est grand temps d'octroyer le droit au scientifique de s'étudier lui-même. Il est grand temps d'octroyer le droit à la communauté scientifique de s'étudier elle-même. Si cette dernière réussit cette métamorphose très profonde et unique au cours de l'histoire des sciences, elle se rendra compte de la nécessité de gommer son complexe de supériorité vis-à-vis des autres modes de pensée. Elle doit s'immerger avec eux et cela ne lui fera pas perdre sa spécificité. Au contraire.

La question c'est comment mettre en place cette métamorphose?

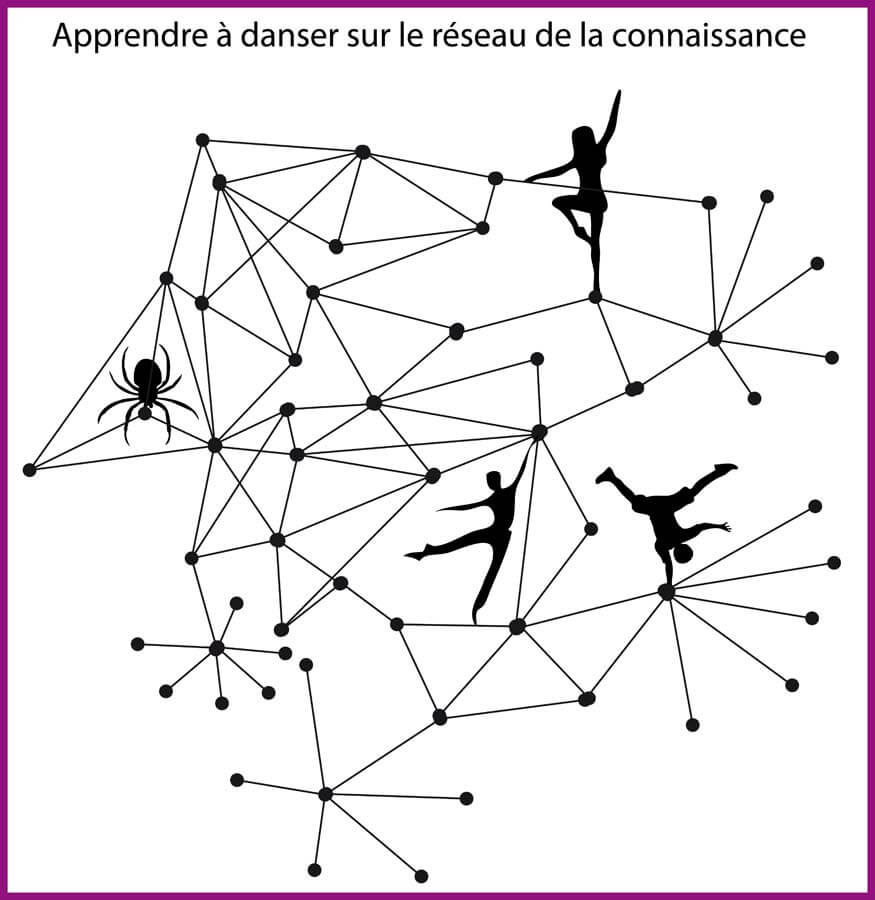

Je pense qu'il n'y aura jamais assez de publications, d'idées et messages publiés et donc plus il y en aura mieux ce sera y compris si "la matrice" de cette ensemble de publication est relativement "creuse" en qualité. Beaucoup de gens, au contraire, pensent qu'il y a trop de publications scientifiques. Par conséquent, ils préconisent de renforcer les filtres pour épurer. Leurs règles c'est "moins mais mieux". Il me semble qu'ils raisonnent selon la mauvaise règle de l'exhaustivité. Le trop grand nombre d'articles les effraie: ils ont peur de ne pas tout contrôler, tout savoir. Ils raisonnent selon des vieux schémas issus de la science du 19ème siècle où l'homme pouvait encore être un "gentilhomme" capable de suivre et de comprendre l'ensemble des domaines scientifiques et culturels. Mais une métamorphose est en marche dans la science du 21ème siècle. Celle-ci renie la sacro sainte règle de l'exhaustivité comme seule manière de mener sa pensée. Il nous faudra apprendre à faire naviguer notre pensée dans un réseau gigantesque d'information. Trouver une information le plus vite possible. Fuir l'établissement à un endroit, fuir le stable mais au contraire voyager, pour endurcir sa pensée. Il est étonnant de voir comment tous les scientifiques vantent les mérites des voyages qui ouvrent les yeux: ils voyagent physiquement à travers le monde pour les congrès et autres rituels d'appartenance à la communauté. Pourtant, leurs pensées semblent parfois restées figées au même endroit pendant des décennies à cause de cette règle de l'exhaustivité. Apprendre à danser avec dextérité sur le réseau de la connaissance, voila ce qu'il faut apprendre à nos élèves.

"A enseigner, on apprend" [mais] "A toujours enseigner, on n'apprend rien" 6

"Là où un homme parvient à la conviction fondamentale qu'on doit lui commander, il devient croyant; à l'inverse, on pourrait penser un plaisir et une force de l'autodétermination, une liberté de la volonté par lesquelles un esprit congédie toute croyance, tout désir de certitude, entrainé qu' il est à se tenir sur des cordes et des possibilités légères et même à danser jusque sur les bords des abîmes. Un tel esprit serait l'esprit libre par excellence " 7

"Et je ne connais rien que l'esprit d'un philosophe souhaite davantage qu'être un bon danseur. La danse est en effet son idéal, son art également, enfin aussi son unique piété" 8

Je rappelle que je ne me place pas à l'extérieur de la communauté scientifique lorsque je la critique. Je revendique totalement mon appartenance à cette communauté et donc je m'autocritique. C'est sans doute pour cette raison que je me permets d'être un peu dur. En secouant la communauté scientifique, je m'auto-secoue. Cependant, il faut savoir aussi reconnaitre les bonnes choses. La communauté scientifique a créé des bases de données gratuites, accessibles à tous et performantes (comme Pubmed par exemple). Un mouvement est initié pour rendre un maximum de publications gratuites à la lecture au grand public (PLOS) et des systèmes de pré-publications existent déja même si ils restent peu utilisés en biologie (arXiv). Le décloisonnement des sciences est peut être déjà en marche. Mais il faut le pousser encore beaucoup plus loin.

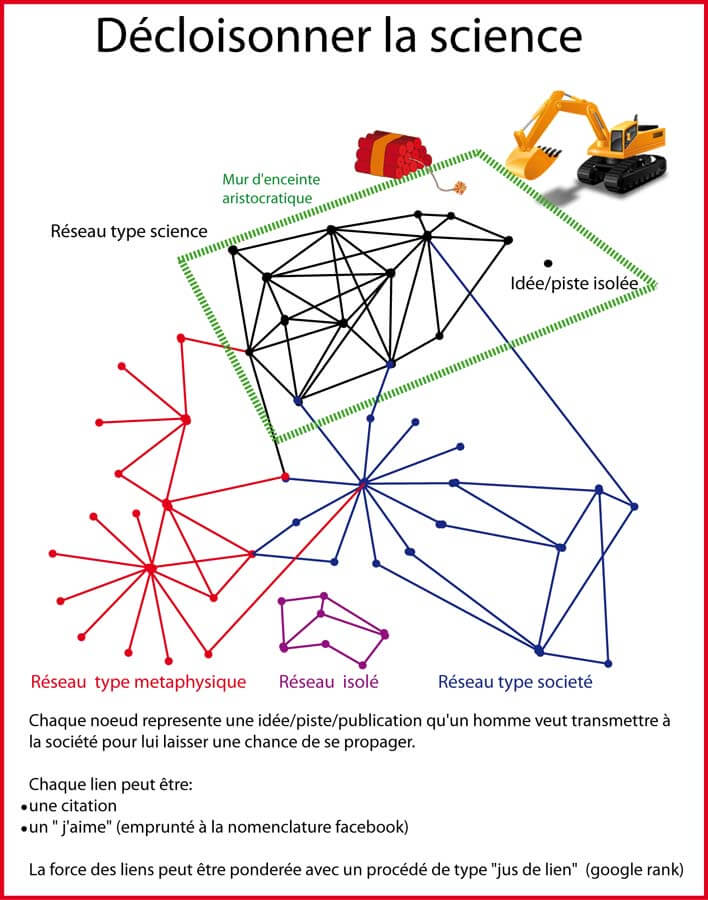

Il faut créer un système où toute personne qui a fait une découverte, a une idée originale, une théorie peut la publier facilement de manière à offrir une chance à cette idée de se propager. Ce système unique doit être le même pour tous. L'auteur doit communiquer son nom (ou un pseudonyme si il souhaite rester anonyme) et chaque article doit pouvoir citer et être cité. Les liens/interactions de ce réseau ne sont pas uniquement les citations. Le lecteur a également la possibilité de cliquer sur le bouton " j'aime" (utilisé par facebook et google). Le poids des "citations" et des "j'aime" pourrait être pondéré par un système de " jus de lien" (utilisé par le google rank) de manière à rendre le système aristocratique. Ainsi, ceux qui ont beaucoup de liens qui pointent vers eux (ceux qui sont très "orientants") créent des liens vers les autres qui ont beaucoup de poids. Ce poids sert à définir des scores: le score n'indique pas quelle est la meilleur idée mais quelle est l'idée la plus "orientante". Il sert à définir l'ordre de présentation des résultats aux lecteurs qui effectuent des recherches avec des mots-clés (comme google). Par conséquent, les publications les plus "orientantes" se propageront plus vite. Ainsi, comme il n'y a pas de critique, toute idée est acceptée pour toujours sur le réseau de la connaissance. Aucune publication n'est rejetée/refusée. Toute publication est bonne à prendre. Tout est bon. Le seul paramètre qui varie c'est son accessibilité/sa visibilité. Ainsi il est possible qu'une idée excellente soit ignorée pendant des années puis soit finalement repérée par la personne à qui elle se destinait. La taille moyenne d'une publication sur la toile doit avoisiner 1 Mega-Octet. Avec 1 Tera-Octet (100 euro), on peut donc en stocker 1 millions. Vous voyez donc que le coup de stockage est minime par rapport à "l'or" que représente une idée. Si un humain juge une idée suffisamment intéressante pour faire l'effort de la mettre en forme sur papier dans le but de la transmettre à l'humanité gratuitement, il faut être fou pour la refuser. Le tout c'est de créer un système capable de classer ces idées et de les présenter au lecteur en fonction de leurs notoriétés.

Vous l'aurez compris, le système ne contient presque aucune règle. Des critères de forme à respecter existent néanmoins de manière à augmenter "l'expérience utilisateur" et ce sont les journaux scientifiques actuels qui pourraient se charger d'effectuer ces vérifications. Il faut donc les rémunérer. Mais comme le système ne nécessite ni revue par les pairs (peer-review), ni prise de décision par l'éditeur, ni impression, les coûts de publication devraient chuter. Leur financement pourrait être soit pris en charge par les états soit pris en charge par l'auteur lui-même. Le système peut aussi inclure un système de "post-review" (voir the faculty of 1000) géré par les éditeurs qui pourraient, à la demande d'auteurs et donc contre rémunération, demander à des "reviewers" de lire une publication et de rajouter ou pas le fameux "j'aime" puis de la citer ou pas dans leurs futurs travaux. Cela n'enlève rien à la publication, ne détruit rien, cela ne peut que rajouter, construire.

Bien sûr, étant donné que le système ne contient presque aucune règle, tout le monde peut publier l'idée qu'il souhaite. Comme sur Wikipedia, inexorablement, les articles scientifiques cohabiteront avec des croyances diverses, dogmes, groupuscules, Madonna, etc...

Mais ce qu'il faut voir / comprendre, c'est que chaque sous-réseau (chaque communauté d'idées) aura une topologie tout à fait particulière. Certaines informations, idées se propageront très vites puis stopperont leurs progressions au bout de quelques jours (idées relatives à l'actualité, aux stars). Les idées relatives aux religions, aux dogmes auront une structure, une expansion différente. Le pari c'est que l'utilisateur sélectionnera le réseau sur lequel il veut se balader sur la base de critères qui représentent fidèlement les caractéristiques de sa communauté de pensée. La science, par exemple, se caractériserait peut être par la robustesse de ses idées au temps qui passe ou par un réseau très densément connecté par des citations créant ainsi une continuité entre les idées passées et futures. Ce qui fait que le scientifique choisirait comme critère de "surfer sur le réseau robuste au temps et densément connecté par les citations". Il ne choisirait plus de surfer sur un réseau qui aurait subi et résisté à la critique comme c'est le cas actuellement. Il n'y a plus d'idées mauvaises rejetées, de scepticisme, de critiques. Il y a des idées qui se propagent et d'autres qui ne se propagent pas. C'est tout. Il n'y a pas de conclusion à tirer vis-à-vis de ces dernières. L'auteur a eu et conserve sa chance. Peut être que son idée n'a pas eu le succès qu'il escomptait mais il peut toujours se rassurer en se disant que peut être demain elle l'aura. Pas de jugement. Pas de critique. Juste la propagation des idées.

Ainsi en décloisonnant la science et en la mettant à la même portée, soumise aux mêmes règles que n'importe quelle croyance, on pourrait gagner en réflexivité en étudiant la topologie du réseau et en le comparant à la topologie des autres réseaux non scientifiques. Les possibles liens entre science et croyances pourraient aussi nous apparaitre plus clairement.

Enfin, j'insiste sur le fait que supprimer la démarcation actuelle entre science et croyance ne signifie pas que celles-ci sont identiques. Ma proposition n'a rien de relativiste. Elle représente au contraire une véritable méthode scientifique pour étudier, justement, ce qui sépare science et non science. Comprendre d'où provient l'asymétrie ressentie entre les énoncés et déterminer si cet asymétrie est réelle ou supposée passe, je le crois, par le décloisonnement du système de publication.

Notes de bas de page

- Bachelard, La formation de l'esprit scientifique, Bibliothèque des textes philosophiques p.301.

- Je précise que je n'ai jamais eu aucun problème avec le système de

- publication/ "les reviewers". Correction : un an plus tard, maintenant j'ai eu "un problème" avec un reviewer qui refuse un de mes articles. Heureusement, ce chapitre était déjà écrit depuis longtemps, on ne peut donc pas m'accuser de l'avoir écrit pour cause d'aigreur prononcée! 😊

- Harry Collins, Tout ce que vous devriez savoir sur la science, p.136.

- Il n'apparait pas très clairement dans l'ouvrage la distinction entre l'homme et son laboratoire.

- Citation de Jean-Noël Lafargue

- Schopenhauer, Les fondements de la morale, le livre de poche p.70.

- Nietzsche, Le gai savoir, Flammarion p. 294.

- Nietzsche, Le gai savoir, Flammarion p. 350.